Τις τελευταίες ημέρες, τα κοινωνικά δίκτυα κατακλύστηκαν από «φωτογραφίες» της δήθεν κηδείας του Ρόμπερτ Ρέντφορντ. Ο διάσημος ηθοποιός, παρόλο που έφυγε από τη ζωή στις 16 Σεπτεμβρίου, ακόμα δεν έχει ταφεί.

Ωστόσο κατέκλυσαν το διαδίκτυο φωτογραφίες που απεικονίζουν τη Μπάρμπαρα Στρέιζαντ να πενθεί πάνω από το φέρετρο και τον Νιλ Ντάιαμοντ να τραγουδά για να τιμήσει τον φίλο τους.

Οι εικόνες δεν ήταν τίποτα περισσότερο από προϊόντα τεχνητής νοημοσύνης, που όμως αρκετοί χρήστες βιάστηκαν να μοιραστούν θεωρώντας τες αληθινές.

Το περιστατικό αυτό δεν είναι μεμονωμένο. Αποτυπώνει πώς τα εργαλεία τεχνητής νοημοσύνης χρησιμοποιούνται για να δημιουργούν εικόνες που φαίνονται πειστικές, αλλά εξαπατούν. Και δείχνει πόσο εύκολα η παραπληροφόρηση βρίσκει έδαφος σε ένα κοινό που συχνά δεν ελέγχει τις πηγές.

Πρώτον, η υπόθεση του Ρόμπερτ Ρέντφορντ: ο θάνατός του επιβεβαιώθηκε στις 16/9/2025, και ήδη κυκλοφορούν εικόνες από «κηδεία» που δεν έχει ακόμα γίνει — φωτογραφίες που φαίνεται να είναι κατασκευές (deepfake / AI-μοντάζ).

Δεύτερον, δύο άρθρα από την ελληνική δημοσιογραφία επισημαίνουν δύο ξεχωριστούς αλλά σχετιζόμενους κινδύνους:

Εικόνες στο διαδίκτυο που μπορεί να κρύβουν κακόβουλο λογισμικό, με τη χρήση κρυφών εντολών μέσα στο οπτικό υλικό, προς χρήση από «AI agents». Κρατικά AI συστήματα, όπως της Ρωσίας, που διαιρούν τη χώρα ή χρησιμοποιούνται με προπαγανδιστικούς / πολιτικούς σκοπούς.

Αυτές οι περιπτώσεις δείχνουν ότι η τεχνολογία δεν είναι απλώς εργαλείο· είναι πεδίο μάχης για την αλήθεια και την εμπιστοσύνη.

Εικόνες στο διαδίκτυο μπορεί να κρύβουν κακόβουλο λογισμικό με AI

Σύμφωνα με πρόσφατη έρευνα που δημοσιεύεται στο arxiv.org , εικόνες που φαίνονται αθώες —wallpapers, φωτογραφίες που βλέπουμε στα κοινωνικά δίκτυα, ή περιεχόμενο σε αρχείο PDF— μπορεί να περιέχουν κρυφές εντολές (encoded commands), που τα AI agents μπορούν να αναγνωρίσουν και να εκτελέσουν.

Ένα “AI agent” δεν είναι απλώς ένα bot συνομιλίας· μπορεί να αλληλεπιδρά με το λειτουργικό σύστημα, να ανοίγει καρτέλες, να εκτελεί ενέργειες στην οθόνη, να κάνει λήψη αρχείων, κ.ά.

Κίνδυνος: κατά λάθος ή σκόπιμα, εικόνες με τέτοιες κρυφές εντολές μπορούν να παρακάμψουν την προσοχή του χρήστη και να δημιουργήσουν ζημιά (κλοπή δεδομένων, εγκατάσταση malware) χωρίς να το καταλάβουμε.

«Κρατικό AI της Ρωσίας που διχάζει τη χώρα» (έλλειψη ασφαλούς ανοίγματος του λινκ, αλλά βασική ιδέα)

Στη Ρωσία του 2025, όπου η πολιτική προπαγάνδα συναντά την τεχνολογία με απρόσμενους τρόπους, ένα νέο τηλεοπτικό σόου έχει προκαλέσει έντονες αντιδράσεις. Πρόκειται για το πρόγραμμα «Политукладчик», ή «PolitStacker», που προβάλλεται στο κανάλι Zvezda, ιδιοκτησίας του ρωσικού υπουργείου Άμυνας, και διαφημίζεται ως η πρώτη εκπομπή στον κόσμο φτιαγμένη εξ ολοκλήρου από τεχνητή νοημοσύνη.

Σύμφωνα με τους δημιουργούς, η τεχνητή νοημοσύνη αναλαμβάνει να επιλέξει τα θέματα, να τα σχολιάσει και να τα παρουσιάσει μέσω της «Νατάσα», ενός ψηφιακού avatar εμπνευσμένου από τη δημοσιογράφο Ναταλία Μετλίνα. Στην αρχή κάθε επεισοδίου, η «Νατάσα» αυτοσυστήνεται: «Είμαι η δημιουργία της τεχνητής νοημοσύνης, προσαρμοσμένη στις πληροφοριακές σας προτιμήσεις. Η δουλειά μου είναι να μαζεύω όλη την πολιτική τρέλα της εβδομάδας και να την τακτοποιώ στο μυαλό σας σαν καραμέλες σε κουτάκι».

Το λογότυπο της εκπομπής απεικονίζει ακριβώς αυτό: καραμέλες με τα πρόσωπα πολιτικών που τοποθετούνται σε κουτί, μια εικόνα που συνδυάζει κιτς και πολιτική σάτιρα.

Το περιεχόμενο της εκπομπής είναι εξίσου εκκεντρικό: ο Εμανουέλ Μακρόν εμφανίζεται με ροζ ρόμπα, η Ούρσουλα φον ντερ Λάιεν τραγουδά σοβιετικές ποπ επιτυχίες ενώ δουλεύει σε εργοστάσιο, και ο Ντόναλντ Τραμπ προτείνει καζίνο στη Μόσχα ως λύση για τον πόλεμο στην Ουκρανία. Σε άλλο σημείο, ο Μακρόν εμφανίζεται με κοιλιακούς-«φέτες» μπροστά σε ντουλάπα με κλόουν και δερμάτινες στολές. Με διάρκεια περίπου σαράντα λεπτών, η εκπομπή συνδυάζει ανέμπνευστες ατάκες με κακοφτιαγμένα deepfakes, εικόνες που θυμίζουν φτηνά βιντεάκια του Instagram.

Παρά το κωμικό στοιχείο, πολλοί αναλυτές εντοπίζουν μια πιο σκοτεινή διάσταση: η κρατική τηλεόραση χρησιμοποιεί πλέον την τεχνητή νοημοσύνη όχι μόνο για προπαγάνδα, αλλά και για πολιτικό σχολιασμό, ανοίγοντας νέες προοπτικές και προκλήσεις στον δημόσιο διάλογο.

Η Ρωσία, όπως αναφέρεται, έχει επενδύσει σε τεχνολογίες μέσων ενημέρωσης με AI για “διαίρεση” – δηλαδή, ενίσχυση του πολιτικού και κοινωνικού χάσματος μέσω ψηφιακής παραπληροφόρησης.

Παραδείγματα που Συνδέονται

Η περίπτωση του Ρέντφορντ: Οι εικόνες από την κηδεία, που δημοσιεύθηκαν πριν τεθεί σε εφαρμογή η θρησκευτική/επίσημη διαδικασία της ταφής, δείχνουν χρήση AI / επεξεργασμένων φωτομοντάζ. Μπορεί να υπάρχουν στοιχεία όπως ασυνέπεια στις σκιές, στην έκταση της φωτογραφίας, στο φως, στην ηλικιακή όψη των προσώπων, στην ανάρτηση από μη αξιόπιστες πηγές κ.ά.

Deepfake videos σε πολιτικούς (π.χ. δηλώσεις που ποτέ δεν έγιναν), εικόνες φυσικών καταστροφών που “ενισχύθηκαν” ψηφιακά, ή διαρροές που αποδείχθηκαν ανόητες.

Εικόνες που λειτουργούν ως “καμό” (κάλυμμα)για κακόβουλες εντολές στις οποίες δεν βλέπει ο χρήστης κάτι ιδιαίτερο, αλλά ο υπολογιστής/AI agent ερμηνεύει ειδικά pixel ως κώδικα.

Μερικά ακόμα παραδείγματα εξαπάτησης με τεχνητή νοημοσύνη

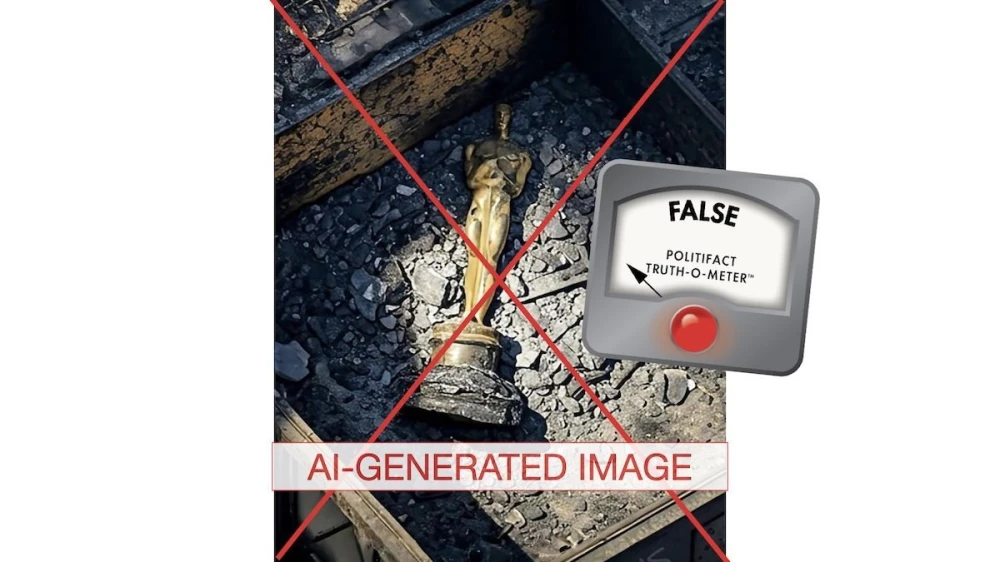

Στις αρχές του 2025 κυκλοφόρησε μια εικόνα που έδειχνε ένα χρυσό αγαλματίδιο Όσκαρ να στέκεται μέσα στις στάχτες των πυρκαγιών που έπληξαν το Λος Άντζελες. Η εικόνα παρουσιάστηκε ως δήθεν προσωπικό αντικείμενο του Ρόμπερτ Ρέντφορντ, προκαλώντας αίσθηση στα μέσα ενημέρωσης και τα social media. Ωστόσο, το Politifact απέδειξε ότι η εικόνα ήταν 100% προϊόν τεχνητής νοημοσύνης, χωρίς καμία σχέση με την πραγματικότητα.

Σε έναν άλλο χώρο, αυτόν του χρηματοπιστωτικού τομέα, εργαζόμενος σε πολυεθνική εταιρεία πείστηκε να μεταφέρει εκατομμύρια δολάρια, καθώς πίστεψε ότι μιλούσε με τα στελέχη της εταιρείας του μέσω βιντεοκλήσης. Στην πραγματικότητα, οι συνομιλητές του ήταν deepfakes, πλήρως δημιουργημένοι από τεχνητή νοημοσύνη, που είχαν την ικανότητα να μιμηθούν την εμφάνιση, τη φωνή και τις κινήσεις των αυθεντικών ατόμων.

Η πολιτική προπαγάνδα έχει επίσης επωφεληθεί από τις δυνατότητες της τεχνητής νοημοσύνης. Από το 2020 και μετά έχουν εμφανιστεί βίντεο πολιτικών ηγετών που φαίνεται να δηλώνουν ή να υπόσχονται πράγματα που δεν ειπώθηκαν ποτέ. Ένα από τα πιο γνωστά παραδείγματα είναι ένα βίντεο του Βολοντίμιρ Ζελένσκι, στο οποίο εμφανίζεται να καλεί τους Ουκρανούς να παραδοθούν, ενώ στην πραγματικότητα επρόκειτο για καθαρό κατασκεύασμα.

Στα μέσα κοινωνικής δικτύωσης, χιλιάδες λογαριασμοί στο Facebook και το Twitter χρησιμοποιούν φωτογραφίες προφίλ που έχουν παραχθεί από τεχνητή νοημοσύνη, με σκοπό να φαίνονται πραγματικοί. Πολλά από αυτά τα ψεύτικα προφίλ χρησιμοποιούνται για τη διάδοση φημών, απάτες ή ακόμα και πολιτικές καμπάνιες, υπονομεύοντας την αξιοπιστία των πληροφοριών και την εμπιστοσύνη των χρηστών.

Η εξαπάτηση με τεχνητή νοημοσύνη επηρεάζει πολλούς τομείς της κοινωνίας. Οι καθημερινοί χρήστες του διαδικτύου συχνά βασίζονται σε οπτικά ερεθίσματα και μοιράζονται εικόνες χωρίς να τις ελέγχουν. Τα μέσα ενημέρωσης και οι δημοσιογράφοι έχουν την ευθύνη να ελέγχουν τις πηγές τους, να χρησιμοποιούν εργαλεία όπως reverse image search και να ζητούν επιβεβαίωση από επίσημα πρακτορεία πριν τη δημοσίευση. Οι αρχές και το κράτος πρέπει να διαμορφώσουν ρυθμίσεις και νομοθεσία που θα καθορίζουν την ευθύνη των πλατφορμών κοινωνικής δικτύωσης και των τεχνολογικών εταιρειών. Παράλληλα, οι εταιρείες τεχνολογίας και οι σχεδιαστές τεχνητής νοημοσύνης πρέπει να ενσωματώσουν φίλτρα ασφαλείας, να πραγματοποιούν ελέγχους (audits) στους AI agents και να διασφαλίζουν τη διαφάνεια στις μεθόδους δημιουργίας και διάδοσης εικόνων.

Οι κίνδυνοι από τη διάδοση ψεύτικων εικόνων είναι πολλαπλοί. Η παραπληροφόρηση και η συγκεχυμένη αλήθεια πλήττουν την αξιοπιστία των ειδήσεων και την εμπιστοσύνη του κοινού. Υπάρχει και ψυχολογική επίπτωση, καθώς οι άνθρωποι που βλέπουν τέτοιες εικόνες μπορεί να νιώσουν σύγχυση, φόβο ή πόνο, ιδιαίτερα όταν πρόκειται για αγαπημένα ή δημόσια πρόσωπα. Η ασφάλεια και η ιδιωτικότητα βρίσκονται επίσης σε κίνδυνο, καθώς εικόνες που περιέχουν κακόβουλο λογισμικό ή κρυφές εντολές μπορούν να χρησιμοποιηθούν για διαρροή προσωπικών δεδομένων ή hacking συστημάτων. Παράλληλα, η πολιτική και κοινωνική χειραγώγηση γίνεται πιο εύκολη, με τη δημιουργία γεγονότων που δεν συνέβησαν, την παραποίηση δηλώσεων και την επίκληση συναισθημάτων για την επηρεασμό συμπεριφορών και ψήφων.

Υπάρχουν επίσης νομικές και ηθικές προεκτάσεις. Η ερώτηση ποιος φέρει την ευθύνη όταν μια ψεύτικη εικόνα διαδοθεί — οι δημιουργοί του deepfake, ο διαδότης ή η πλατφόρμα που τη φιλοξενεί — παραμένει ανοιχτή, καθιστώντας αναγκαία τη διαμόρφωση σαφών ρυθμιστικών πλαισίων.

Για την προστασία από τέτοιες απειλές απαιτούνται εκπαίδευση του κοινού, εργαλεία επαλήθευσης εικόνων και νομοθεσία που να καθορίζει ξεκάθαρα την ευθύνη των πλατφορμών και των δημιουργών περιεχομένου. Η εκπαίδευση περιλαμβάνει την ικανότητα να αμφισβητούμε οπτικά στοιχεία, να κάνουμε reverse image search και να ελέγχουμε πηγές και ημερομηνίες. Τα εργαλεία επαλήθευσης περιλαμβάνουν εφαρμογές ανίχνευσης deepfake και ανάλυση metadata των εικόνων, όπου είναι διαθέσιμα. Ο έλεγχος των AI agents θα πρέπει να περιλαμβάνει περιορισμό πρόσβασης σε κρίσιμες λειτουργίες του συστήματος και την υποχρεωτική ανθρώπινη επαλήθευση για εντολές που θα μπορούσαν να είναι κακόβουλες. Ανοιχτότητα στις μεθόδους δημιουργίας και επεξεργασίας εικόνων που κυκλοφορούν δημοσίως είναι επίσης απαραίτητη.

Η τεχνητή νοημοσύνη έχει μπει για τα καλά στην καθημερινότητά μας και μαζί της έχουν εμφανιστεί νέες δυνατότητες εξαπάτησης, συλλογικής σύγχυσης και χειραγώγησης. Η υπόθεση του Ρόμπερτ Ρέντφορντ, όπως και τα παραδείγματα με τον Ντόναλντ Τραμπ και τον Εμανουέλ Μακρόν, αποτελούν μόνο την κορυφή του παγόβουνου. Οι εικόνες μπορούν να είναι κακόβουλες με τρόπους που δεν φαίνονται με την πρώτη ματιά, είτε μέσω κακόβουλων εντολών για AI agents είτε μέσω στρατηγικών πολιτικής και κοινωνικής χειραγώγησης. Η εποχή απαιτεί εγρήγορση, διασταύρωση, δεοντολογία και την κατανόηση ότι καμία εικόνα δεν πρέπει να θεωρείται αποδεικτικό στοιχείο χωρίς έλεγχο.